4.2偏最小二乘PLS

一、基本原理

偏最小二乘多用于寻求两个矩阵(X和Y)的基本关系,也就是一种在这两个向量空间中对协方差结构建模的隐变量方法。

偏最小二乘模型将试图找到X空间的多维方向来解释Y空间方差最大的多维方向。

偏最小二乘回归特别适合当预测矩阵比观测的有更多变量,以及X的值中有多重共线性的时候。通过投影预测变量和观测变量到一个新空间来寻找一个线性回归模型。

公式:

偏最小二乘回归 ≈ ≈≈ 多元线性回归分析 + ++ 典型相关分析 + ++ 主成分分析

特点:

与传统多元线性回归模型相比,偏最小二乘回归的特点是:

- 能够在自变量存在严重多重相关性的条件下进行回归建模;

- 允许在样本点个数少于变量个数的条件下进行回归建模;

- 偏最小二乘回归在最终模型中将包含原有的所有自变量;

- 偏最小二乘回归模型更易于辨识系统信息与噪声(甚至一些非随机性的噪声);

- 在偏最小二乘回归模型中,每一个自变量的回归系数将更容易解释。

在计算方差和协方差时,求和号前面的系数有两种取法:当样本点集合是随机抽取得到时,应该取1/(n-1);如果不是随机抽取的,这个系数可取1/n。

在过程监控中,PLS类型的监控,包括非线性PLS,使用质量数据指导过程数据的分解,并提取与产品质量最相关的潜在变量。由于使用了质量数据,在质量相关性方面的诊断能力得到了增强,误报率降低。

首先让我们回顾一下 CCA 的知识。在CCA中,我们将X和Y分别投影到直线得到U和V,然后计算u和v的Pearson系数(也就是Corr(u,v)),认为相关度越大越好。形式化表示:

$$ Max: R_(U,V) = a_i^TCov(x,y)b_j $$

$$ S.t: Var(U) = Var(V)=1$$

其中a和b就是所需要的投影方向,只需要求得R_(U,V)_{max} 即可。其中运用拉格朗日乘数法求解。

关于CCA的缺点:对特征的处理方式比较粗糙,用的是线性回归来表示U和X的关系,U也是X在某条线上的投影,因此会存在线性回归的一些缺点。我们想把PCA的成分提取技术引入CCA,使得U和V尽可能更多的携带样本的最主要信息。Most important thing!CCA是寻找X和Y投影后U和V的关系,通过系数矩阵求其最优解使得R ( U , V ) 最大,显然不能通过该关系来还原出X和Y,也就是找不到X到Y的直接映射。这也是使用CCA预测时大多配上KNN的原由吧。

PLS兼顾了PCA和CCA,解决了X和Y在投影上映射问题。

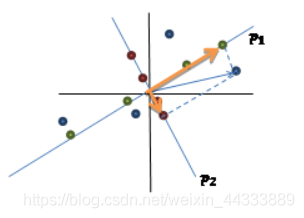

如上图所示,假设对于CCA,X的投影直线是p 1 ,那么CCA只考虑了X的绿色点与Y在某条直线上投影结果的相关性,丢弃了X和Y在其他维度上的信息,因此不存在X和Y的映射。

然而,PLS回归会在CCA的基础上引用了PCA投影的办法,使得丢失部分得以映射。图上的原始蓝色点表示的是绿色点和红色点的叠加,故先对X的绿点t 1 对Y做线性回归, $ Y=t_1r_1^T+F$

同理,再对X的红色点t 2 对Y的剩余部分F 做线性回归,$F=t_2r_2^T+F' $ ;这样Y就是两部分回归的叠加。

这样的话,当我们接受一个新X ′的时候,我们就会得到绿色点t 1和红色点t 2 ;然后,再通过两者的r 即可求得还原出Y 。从而可实现了X到Y的映射。

PLS算法

https://blog.csdn.net/weixin_44333889/article/details/119420315

参考资料